現状のCV率に満足しているというマーケターは、全体の28%しかいないことが統計からわかっています。みなさんの中にも、現在のCV率に満足できていないという方は多いのではないでしょうか?

この課題を解決する為には、A/Bテストを効果的に活用することが最も効果的です。しかし、A/Bテストを行う上で、どれくらい検証期間を設けていいか分からなかったり、どんな検証を行えばいいのかわからないというマーケターの方も多く存在します。

本記事は、実際の成功事例を参考に、A/Bテストを実施する期間と、効率のいい運用方法について明らかにしていきます。

A/BテストでCV率が向上するのは事実?

そもそもA/Bテストとは何でしょうか?

A/Bテストとは、同じコンセプトを持つ2つのバリエーションを比較し、どちらのパフォーマンスが高いか評価するための手法です。

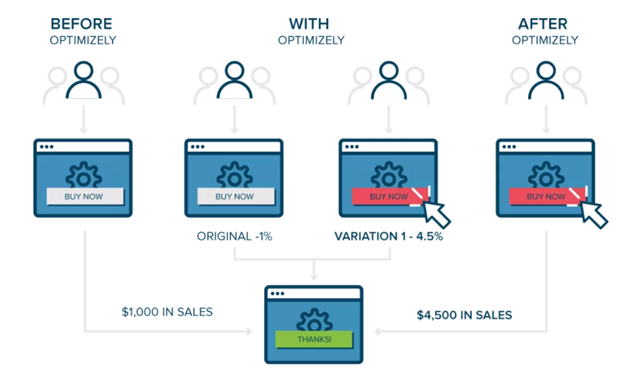

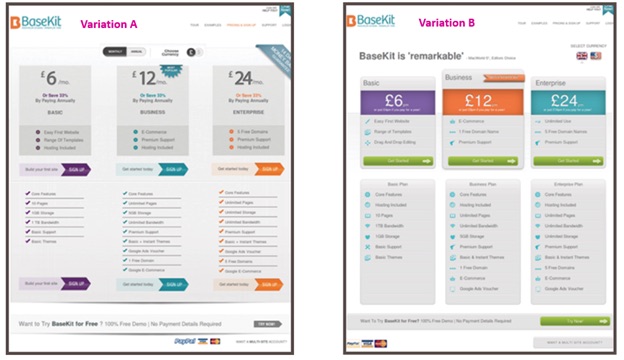

下の画像は、「Optimizely」を使用したA/Bテストの簡単な例です。

A/Bテストを実施することで、サイトやアプリを始めとするあらゆるコンテンツをどのように改善するべきか適確かつ具体的に検討することができます。

さらに重要なのは、A/Bテストを通して実際のオーディエンスの反応を知ることが出来る点です。

では、A/Bテストにはどのような利点があるのでしょうか?

1つ目の利点は、A/Bテストを実施することで仮説の土台となるデータを得ることができるため、見当違いの憶測に基づいて行動する可能性が低くなることです。

予算を設定してから達成するまでに、おおざっぱな憶測のみで運用してしまうと成果を出すことは難しいです。

「Kiva.org」の例を見てみると、FAQに統計結果を載せただけで、CV率が11.5%上昇しています。

細かい点ですが、こういった小さな積み重ねで成果を得ることができるのです。

オバマ大統領の選挙キャンペーンでも、A/Bテストを使用しています。オバマ陣営はキャンペーン用のウェブサイトでA/Bテストを実施した結果、280万件のメールアドレスを追加で収集することができました。

これをキャンペーン資金に換算すると、6,000万ドル (約66億円:2018年6月現在) もの大きな額になります。

このように大きな効果を見込むことができるにも関わらず、A/Bテストを実施するマーケターが増えないのはなぜでしょうか?

それはマーケターがA/Bテストの優先順位を低く考えているケースが多く見られるためです。

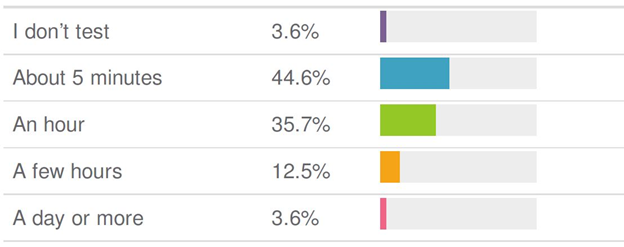

ウェブサイトの場合、A/Bテストを実施するとCV率が平均13.2%増加します。それにも関わらず、マーケターの61%は、タイトルのA/Bテストを実施していません。また、A/Bテストを実施したとしても、マーケターの74%はタイトルのテストに1時間も割いていませんでした。

A/Bテストを重要視していないマーケターは、そもそも測定しているものが適切ではなかったため、変更を加えても大きな成果に繋がらなかった可能性があります。そのため、A/Bテストで効果は得られないと勘違いしていることも多いのです。

しかし実際は、A/Bテストにより新規顧客がB2Bサイトでは最大40%、ECサイトでは最大25%増加することがわかっています。

企業によっては、A/Bテストを実施しないという判断が妥当である場合もあります。

1ヶ月のCV数が1,000件未満である場合、A/Bテストの用意が整っているとは言えません。テストを実施しても結果に統計的有意性がないためです。

この場合はCV数が1,000件を超えるまで待ちましょう。1,000件を超えれば、信頼性のあるA/Bテストを実施できます。信頼性があるということは、結果に何かしらの意味があるということです。

この点については、後半で詳しく解説します。

一定期間A/Bテストを実施してみたものの、努力に見合った成果を得られていないと感じていませんか?A/Bテストが失敗に終わる主な原因は次のようなことが考えられます。

- テスト開始時の仮説が間違っている

- 統計的有意性が得られていない

- テストが効果を発揮できるだけのCV数を得られてない

- テストを実施する期間が足りていない

A/Bテストが時間の無駄になってしまわないように、失敗を引き起こさないための方法を紹介します。

自分で調査を実施する

A/Bテストを始める第一段階として、テストすべき項目を決める必要があります。

素晴らしい結果を残したA/Bテストはいずれも、高度な仮説に基づいています。

しかし現実には、テストをデータや入念に検討した仮説ではなく、「直感」に基づき実施しているサイトオーナーが多くいます。

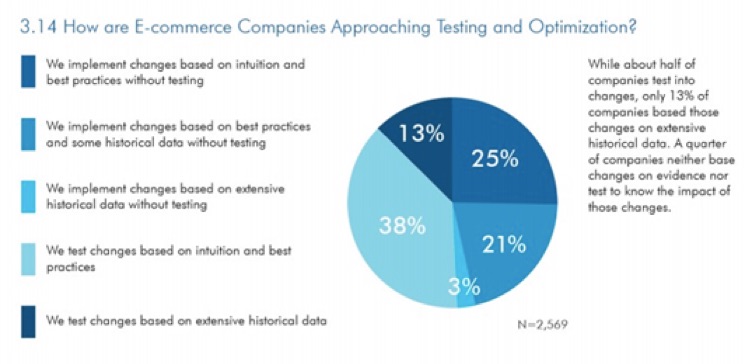

2014年に作成された下の円グラフは、ECサイト企業がどのような手法に基づいて、新たな変更を加えるという判断を下したかを表しています。

このグラフからも「直感」による仮説からテストを行なってしまっているマーケターが多くいることは明らかです。

変更を加える時には、適切なテストを実施し、得られたデータに基づき行いましょう。

まず、自分の企業にとって順調に進んでいないものを調べる必要があります。

不足しているものを特定したら、それを達成可能な数値の目標を設定しましょう。なるべく具体的かつ測定可能な目標にしてください。

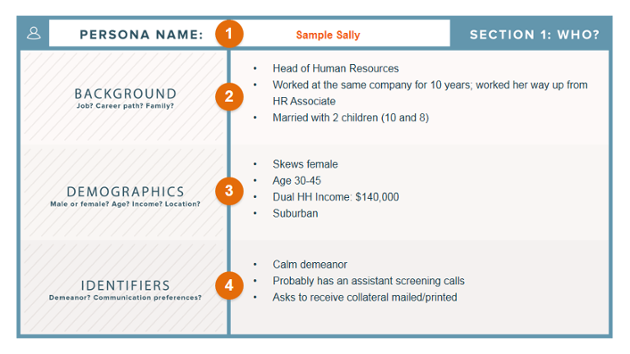

次に、ユーザーのペルソナ (人物像) を調査しましょう。この調査を一定期間行わないと、実際にCVするユーザーとターゲットが乖離してしまい、機会を逃してしまうことがあります。

「HubSpot」は、様々な購入者像の作成に便利なテンプレートを提供しています。

オーディエンスについて把握できている情報を使用し、顧客を満足させられていない原因が何なのか時間をかけて、十分に検討しましょう。

大変な苦労をして作り上げたコンテンツの欠点を探すというのは、簡単な作業ではありません。しかしこれが極めて重要なステップとなるのです。

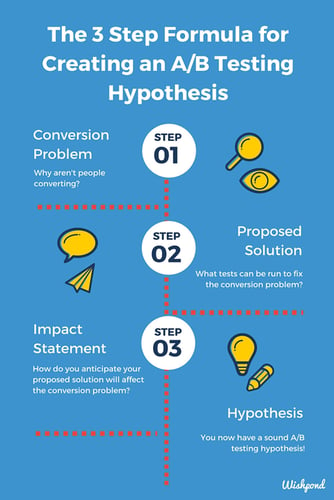

改善できる点を詳しく把握できたら、次は仮説を組み立てていきます。

現実的に変更可能なものに対象を絞っていきましょう。「Wishpond」は3つのステップを推奨しています。

仮説を組み立てることは難しい作業ではありません。難しいのはおそらく、問題を絞り込み、最初にテストする項目を把握するために、最も優先度の高い問題を特定することです。

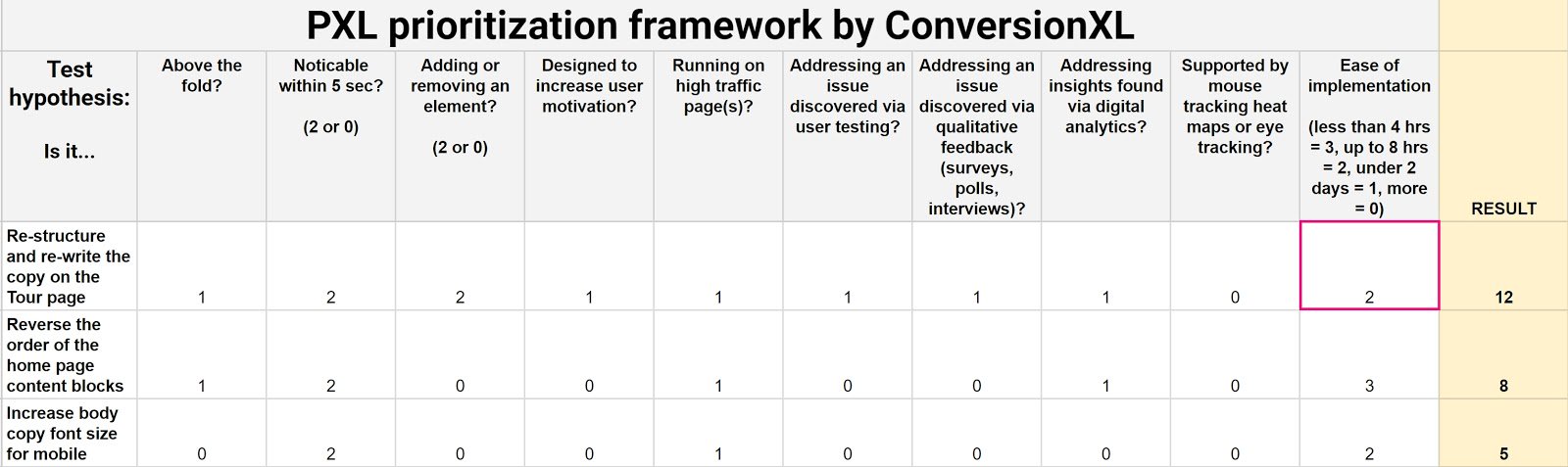

「Conversion XL」が優先順位を決めるためのワークシートを用意してくれています。最初に取り組むべき事項を特定する上で、このワークシートを活用しましょう。

これでようやく仮説が完成しました。この仮説を使ってテストを実施しましょう。

重要なのは統計的有意性

統計的有意性とは、テストで得られた結果が本当に正しいと言えるのかどうかを示すものです。

「Optimizely」によると「統計的有意性とは、ある統計が信頼できることを数学的に証明する方法です。実施中のテストの結果に基づき判断を下す時には、実際にどのような相関関係が存在するのか確認しなければなりません」と表記されています。

意味のある結果を得るためには、95〜99%の統計的有意性を得られるまでテストを中止してはいけません。95〜99%の統計的有意性があるということは、95〜99%の信頼性をもった結果であると言え、初めてそのデータを活用できるからです。

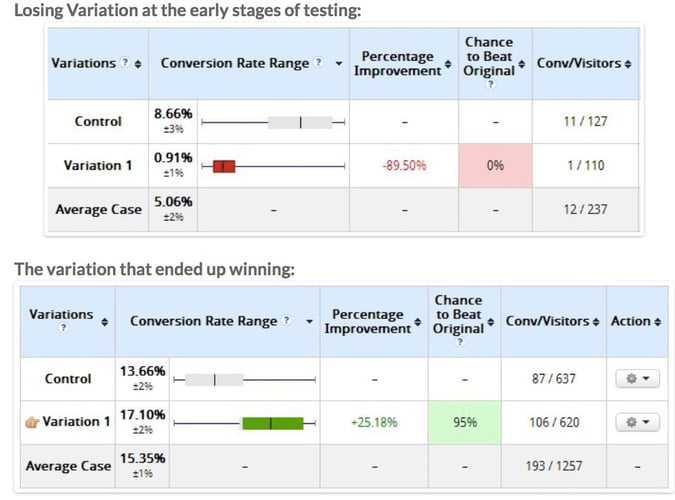

ここで「ConversionXL」が紹介している例を見てみましょう。

データを見てわかるように、テストを実施してすぐの段階では、Variation 1は、採算性の低い提案であるように見えます。しかし統計的有意性が95%に到達するまで待ってみると、結果は完全に違ってきます。最終的にVariation 1ではCVが25%上昇することがわかり、最も優秀なバリエーションとなりました。

テストをすぐに中止してしまうと、間違った結果が出てしまうことがあり、テストを実施した意味がなくなってしまうのです。

もうひとつ、「Basekit」の例を見てみましょう。「Basekit」はオンラインでウェブサイトの開発を行う企業です。

「Basekit」の場合はトラフィックの大半が有料なので、オーディエンスが「Basekit」の製品に十分関心を持っていると仮定して間違いないでしょう。そのため価格ページを重点的にテストすることにしました。

Basekitのテストでは、テスト開始から24時間以内に統計的有意性が95%に達しました。価格ページのデザインを修正しただけで、全体的なCVが25%上昇しました。

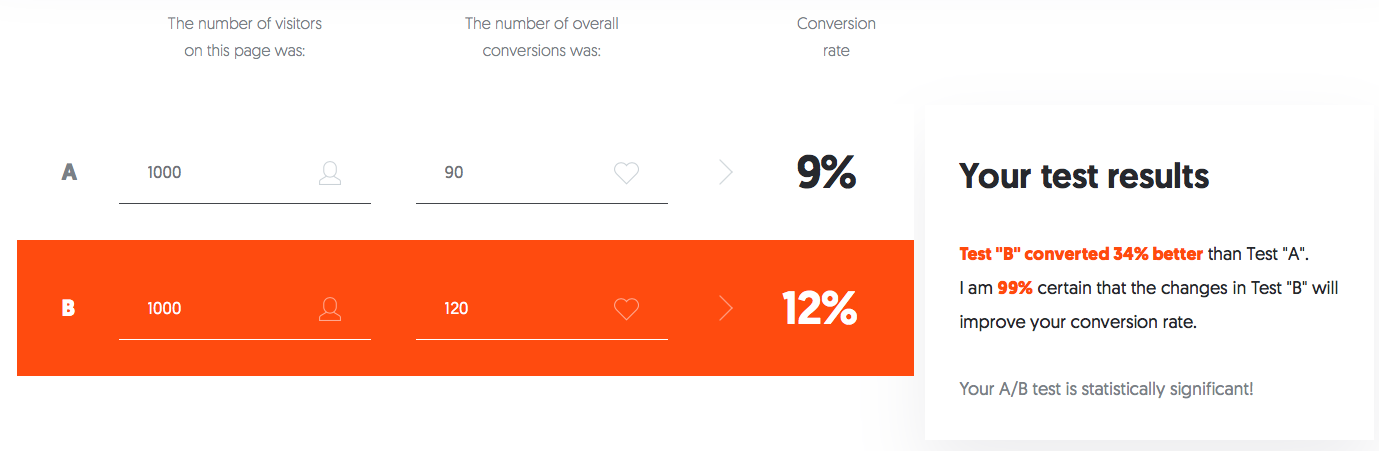

3つ以上のバリエーションをテストしたくなった場合、このツールを活用すれば好きなだけバリエーションを追加し、それぞれの有意性を解析できます。

また、このツールは訪問者数と、テストするバリエーションの総CV数を入力するだけで、2つのCV率を自動的に比較し、テストに統計的有意性があるかどうか示してくれます。

繰り返しになりますが、統計的有意性が95%以上に達していなければ、テストを続けましょう。

統計的有意性が適切なレベルに達したと「思われる」ところでテストを中止してはいけません。95%に達するまでは決してテストを止めないでください。99%の統計的有意性を目標とすることをお勧めします。 しかし統計的有意性を確保することだけがA/Bテストを成功に導く要因ではありません。配信対象によってもテストの結果は大きく変わります。

配信対象者数

配信対象者数が少ない場合、または既に獲得しているCV数があまりに少ない場合には、大きな誤差が発生する可能性があります。

次のように考えてみましょう。ひとつの袋にゼリービーンズが100個入っています。そして袋の中から異なる味のゼリービーンズを引き当てる確率を調べるために、テストを実施するとします。

袋から3つのゼリービーンズをランダムに取り出します。すると3つとも同じ味でした。この結果から、この袋には同じ味のゼリービーンズしか入っていないと決めつけてしまうと正確な測定ができません。

袋に入っていたすべてのゼリービーンズの中に、同じ味は4つずつしかなく、偶然にも最初の1回でそのうちの3つを選んでしまっただけという可能性があります。または半分が同じ味で、もう半分が違う味だったかもしれません。

どのような場合であっても、3つのゼリービーンズだけを使い42回目以降にゼリービーンズを引き当てる確率を決めてしまうと、正解の数値よりもかなりずれた結果を算出してしまうことになります。

あるいはゼリービーンズを3つ取り出した時に、同じ味がひとつも出なかった場合、袋から同じ味を引き当てる可能性はゼロという間違った結果が出てしまうのです。

どちらの場合も妥当な結論を導き出すにはテストの配信対象があまりにも小さかったために、間違った結果が出てしまいました。

では、テストを成功に導くためには、どの程度のCV数、または対象者数を確保しておくべきなのでしょうか?

全体的な訪問者数とCV数によって多少の差はありますが、テストを実施する時には少なくとも1,000人の対象者(CV数や顧客数、訪問者数)を確保しておくことが賢明です。そうしなければ正確な結果を得ることは難しいです。

マーケティングの専門家の中には、5,000人以上の配信対象者数を推奨している人もいます。

A/Bテストを実施する時に考慮すべきポイントとして、見落としがちなことがもうひとつあります。それはサンプルとするオーディエンスが、CVの母集団全体を代表するようなオーディエンスでなければならないということです。この点に注意しておかなければ、サンプルが原因となってテストに誤作動が生じ、間違った結果が出る可能性があります。

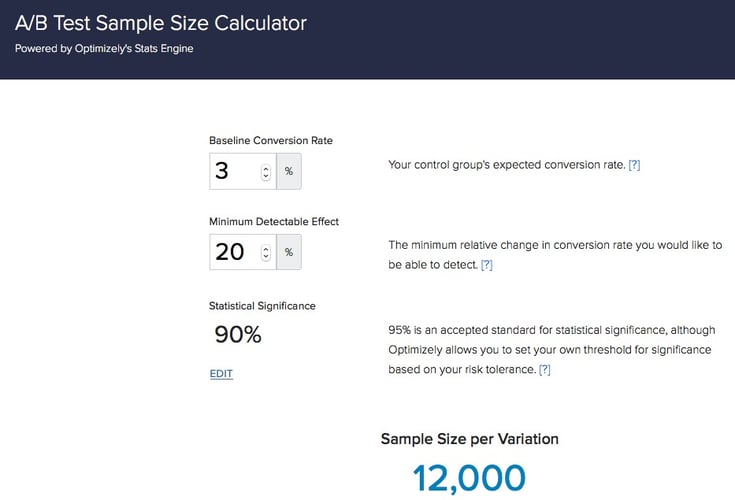

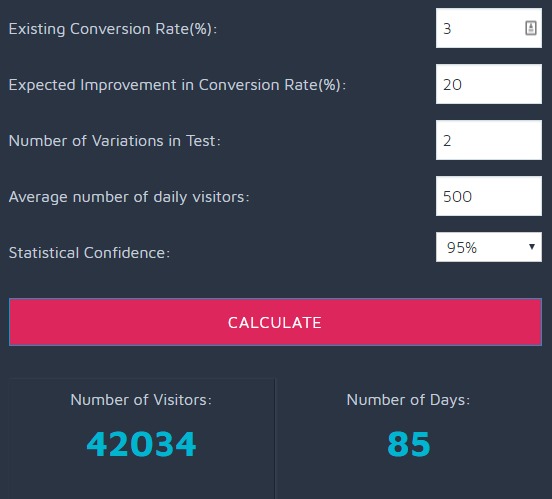

どの程度の規模の配信対象者を確保すべきか悩んでいる場合には、Optimizelyの計算ツールで、理想的な配信対象を決めることができます。さらにこのツールでは、統計的有意性も計算することが可能です。

ではサンプルに起こる誤作動にはどのようなものがあるのか、一般的な例を紹介します。

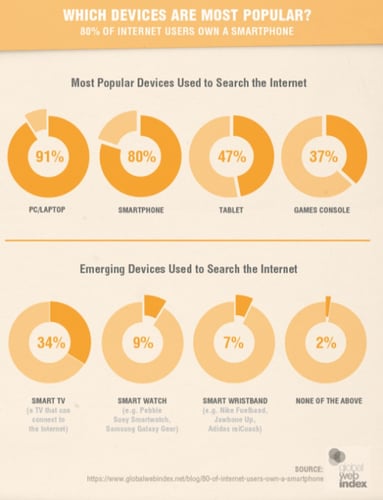

このサイトでは、訪問者の多くはPCやタブレット、テレビを使ってコンテンツにアクセスしています。

訪問者は多種多様なデバイスからウェブサイトやコンテンツにアクセスしているのです。

この訪問者ひとりひとりをデータに含むと、デバイスに起因する誤作動が生じます。ひとりの訪問者を複数回数えているためです。

他にも複数のユーザーがひとつのデバイスを共用している場合、誰でもアクセス可能なデバイスからアクセスしている場合など、考慮しなければならない要因があります。サンプルに起因する誤作動に関しては、あらゆるユーザーを想定し、事前に検討を重ねておくことが大切です。

具体的な方法として、A/Bテストを特定のデバイス、ブラウザごとに分けて実施するというのがひとつの手です。

ここからはA/Bテストの最も重要なポイントであり、マーケターなら必ずどこかで直面する、テストの実施期間について見ていきましょう。

我慢が重要

マーケターは答えが見つかったと思い、A/Bテストを早い段階で終了してしまうという失敗をよく犯します。

どのバリエーションが一番効果があるのか早まって決めてしまうと、正しい結果が得られず、テストは無駄になってしまいます。

テストから正確な結果を得たいのであれば、そのプロセスを最後まで我慢強く見守りましょう 絶対に統計的有意性が95%以上になるまでテストを中止してはいけません。

CVとウェブトラフィックは日によっていくつかの重要な変数で大きく変化するため、正確なデータを得るためには最低でも2週間はテストを継続することが理想的です。

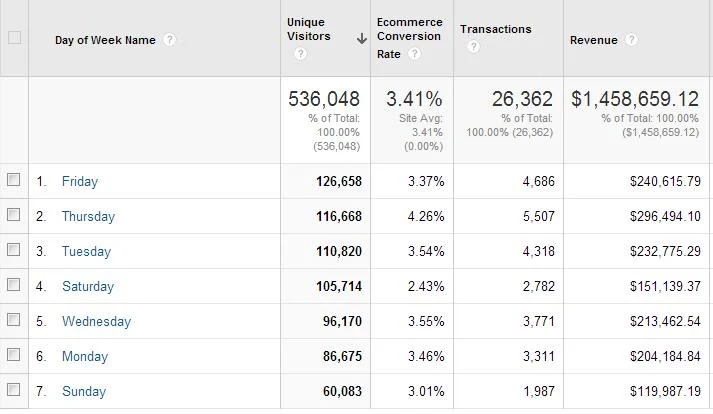

Conversion XLから得られたデータを見てみましょう。

データから、CV率が週末よりも火曜日にかなり高くなっていることがわかります。この場合、1週間テストを続けなければ、結果が大きく変わってしまうでしょう。

最短でも7日間はテストを続けた上で、統計的有意性を得られたことを確認するということをルールにしましょう。ここで統計的有意性が不十分であれば、もう1週間テストを続けることも検討してください。

データに関しては、多すぎるに越したことはありません。A/Bテストの計画には最初からテスト期間を考慮するようにしましょう。

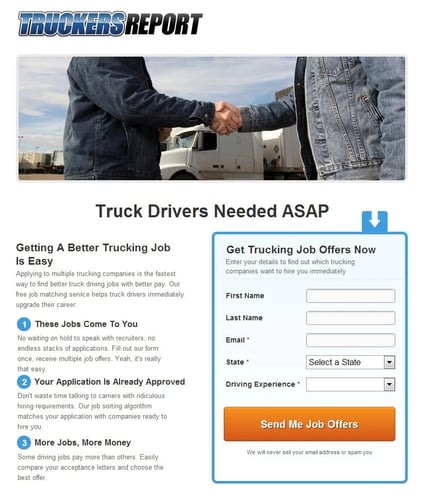

トラックドライバーの求人サイト、「TruckersReport」の例を見てみましょう。下の画像は、「TruckersReport」がもともと公開していたランディングページです。

一見したところ、何も問題はないようです。しかしこのランディングページでは、好ましい結果を得ることができず、CV率が12%で伸び悩んでいる状況でした。

ここで修正版のデザインと比較してみましょう。

レイアウトを新しくしたことで、「TruckersReport」のCV率は79.3%まで上昇しました。

どのようにしてここまでCV率を向上できたのでしょうか?

「TruckersReport」の場合は、6カ月に渡り、合計6回のA/Bテストを繰り返し実施しました。 「TruckersReport」は95%の統計的有意性を確保しただけでなく、考えられる全てのトラフィックのパターンを考慮したのです。

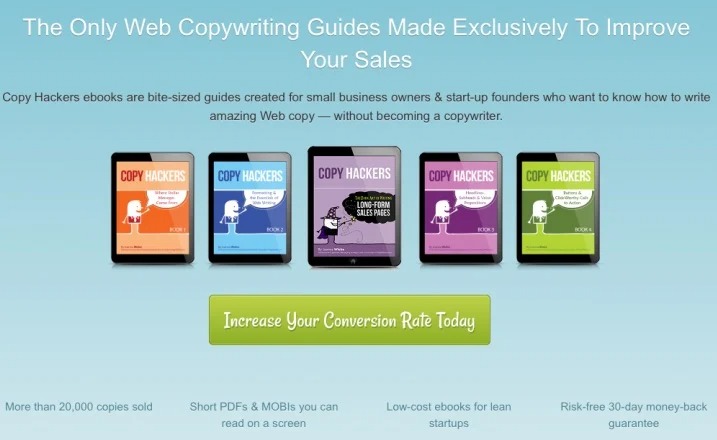

ここでもうひとつ例を紹介します。コピーライトの作成会社である「Copy Hackers」は、ホームページ上でA/Bテストを実施しました。

「Copy Hackers」の場合はテストを開始してから数日たっても、決定的な結果が得られませんでしたが、6日後に統計的有意性が95%に達しました。ここでテストを終了してしまうマーケターもいるでしょう。しかし「Copy Hackers」はテストを止めませんでした。

まだテスト開始から丸1週間経っていなかったので、もう1日テストを続けたのです。1日待ってみると、全く別のバリエーションがCVをほぼ24%向上するという結果が出ました。またもう1日待ってみたことで、95%だった有意性が99.6%に上昇しました。

このように辛抱強く待つことが、大きな成果に繋がります。

しかしいくら待ってみても (例えば数カ月) 、各バリエーションに明確な差が出てこない場合には、どうすべきでしょうか?

今回紹介したすべての手順を踏んだ上で、最も優秀なバリエーションがはっきりしない場合には、いったんテストを止め、新しいバリエーションを使ってテストをやり直しましょう。

Convertは、A/Bテストの実施期間を計算する便利なツールを提供しています。データの整合性を維持するためにはどれくらいの期間テストを実施すべきか知りたい時に、このツールを使用してください。

結論

マーケティング業界では、A/Bテストに関して様々な意見があります。しかし今回の記事で紹介した企業がA/Bテストを通して得た結果を否定することはできません。

A/Bテストに否定的な意見はありますが、A/Bテストを正しい方法で実施することでCVを上昇することが可能になります。 A/Bテストを試したことがないという人や、過去にA/Bテストがうまくいかなかったという人は、これを機会にぜひ試してみてください。

以下にA/Bテストを成功させるためにポイントをまとめました。

- 正しい仮説を組み立てる。根拠のない憶測や、直感に従ってはいけません。

- 95〜99%の統計的有意性を得られるまでテストを続ける。

- 十分な配信対象者数(少なくとも1,000件のCV)を確保する。

- 早い段階でテストを中止しない。少なくとも1〜2週間は続けましょう。

正確かつ辛抱強くA/Bテストを行い、CV率を上昇させてください!

この記事は、NEILPATEL社のブログHow Long Should I Run My A/B Test?"を著者の了解を得て日本語に抄訳し掲載するものです。Repro published the Japanese translation of this original article on NEILPATEL in English under the permission from the author.