Google Analyticsなどのアクセス解析ツールは、ASOを向上させるために非常に重要なツールの1つです。しかしGoogle上でA/Bテストの効果的なパターンを洗い出せたとしても、実環境に反映した時に思ったような効果が出ないことがあります。

この記事はINCIPIA社が行ったA/Bテストから分かった事とASOに詳しいThomas Petit氏からのアドバイスをまとめたものです。A/Bテストを行う際に、参考にしてみてください。

Google Playの90%信頼区間を理解する

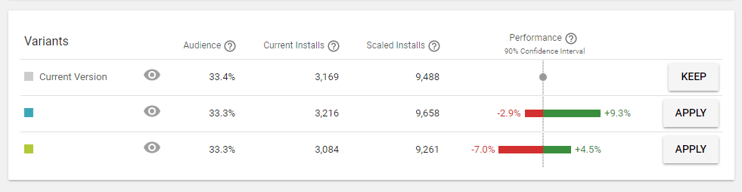

Thomas氏が資料の中でも指摘しているように、90%の信頼区間では確実な結果を保証できない上、コンバージョンに繋がる訳でもありません。

それでは、90%信頼区間における3%から15%とはどういう意味でしょうか? これはインストール率が90%改善するという意味ではなく「もし100回テストをしたら90回はコンバージョン率が3%から15%という結果を得られる」という意味です。

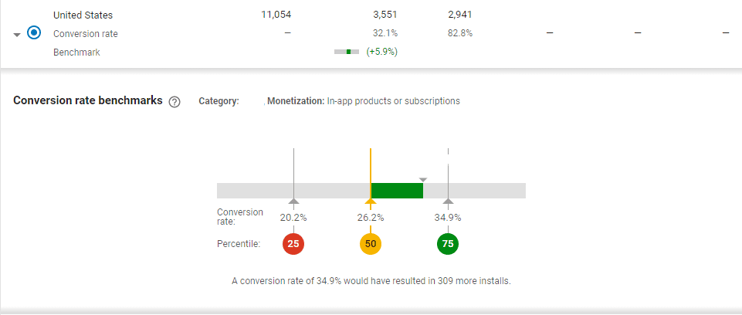

つまり、下限値が5%から10%以下の場合はテストをしないほうが良いということになります。(下記の画像を参照してください)

十分なデータを用意した上で信頼度をあげる

Googleで表示される信頼区間の値は、複数のテスト結果を元に算出されています。テストで流すデータが極めて少ない場合、違いが出にくくなるため信頼区間の値に誤りが出やすくなるのです。信頼性の低いテスト結果が出てしまいます。

そこで、テストの信頼性をあげる方法を4つご紹介します。

1. 優位性の見られないテスト結果は意味がないものとする

上述した通り90%信頼区間は最適ではありません。しかし、90%信頼区間でも統計的に割り出したデータであり、人が感覚で判断するより信頼できる値です。テスト結果が圧倒的優位と認識できない場合は、実環境でリリースしても効果が出ないでしょう。

2. テストデータは少なくとも3日から7日分のデータを含むか、1つのテストサンプル内に1,000以上のインストールデータがあること

テストサンプルがそれぞれ特殊だったりインストール数が少なすぎる場合、A/Bテストの結果に偏りがでることがあります。

Googleはユーザーをランダムに選定していますが、キーワードサーチから流入した比較的コンバージョンの高いユーザーがサンプルのどれかに偏る可能性もあります。ですので、テスト結果に影響が出ないように注意しなければいけません。また3日未満のテストデータは使うべきではないでしょう。

3. 少なめのテストサンプル数で順番にテストするか、ユーザーエージェントを駆使して早く結果を得る

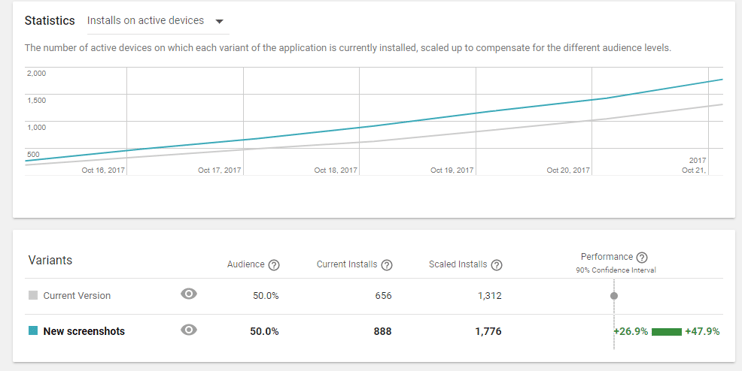

4. テストの期間中はトレンドが一定であることを確認する

数日にわたって安定した結果が出ていれば、テスト結果は信頼できるものと考えていいでしょう。

B/Aテストを行う

テスト結果の信頼性を上げるためB/Aテストを行うことをThomas氏は推奨しています。 Bというのは基準となるAに対する比較です。

基本的には、Aを基準にA/Bテストを実施してBと比較しますが、Bに対してAを比較した時に結果が同じであれば、テスト結果の信頼度は高まります。B/Aテストをすると結果が変わることが多くあるため、結果を見て驚くかもしれません。その場合は異なるサンプルで再度テストしてください。

実環境での効果を予測する

B/Aテストと同時に得たコンバージョン率を元に、実環境に反映した時のコンバージョンの変化を予測しましょう。 テストを行う国や地域を決めたら、テストを始める前のコンバージョンを測定します。そうすることで全体のコンバージョンに影響が出ていないかを確認することができるのです。

テストを実施する1週間前からのデータがあれば十分ですが、数週間分のデータがあれば傾向が掴めるのでなお良いでしょう。リリースしてから数日から数週間はコンバージョンのデータが確定しないので気をつけてください。

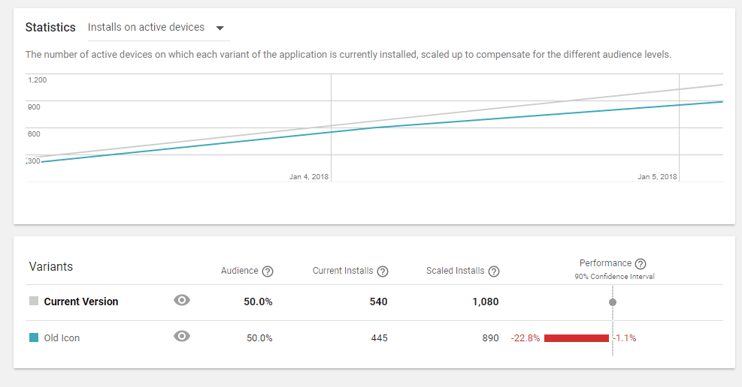

悪い結果は3日で中止すること

3日、もしくは2日であっても、連日著しく悪い結果が続く場合はテストを中止していいでしょう。その悪い結果が、アプリのASOに悪影響を及ぼす可能性があるからです。

テストは一部のユーザーに向けてしか表示されないため、実環境に置いて大きな悪影響に繋がることはないでしょう。特にユーザー数が多く、テストサンプルが少ない場合、問題になることはありません。

この記事は、INCIPIA社のブログ"5 Pro A/B Testing Tips"を著者の了解を得て日本語に抄訳し掲載するものです。Repro published the Japanese translation of this original article on INCIPIA in English under the permission from the author.