2021.01.27

A/Bテストについて勉強している新人マーケターにとっては、その可能性は無限で明るいものだと思えるかもしれません。統計的に有意な変更をたくさん行い、アクションを促すボタンの色を微調整することでコンバージョン率を10%上昇させることもできます。

しかし実際には、A/Bテストはとっつきやすいものではありません。多くのA/Bテストは否定的な結果、または(もっと悪い場合)は変化なしに終わります。さらに、一度にたくさんの変数をテストしてしまうと、変更点と結果を結びつけることが難しい一見矛盾した結果に終わることもあるのです。

しかし、失敗したA/Bテストを生かす方法はあります。結果をどう読み取るかが大事です。決定的でなかったテストから新しいことを学び取るいくつかの方法を見ていきましょう。

出典: Unsplash

出典: Unsplash

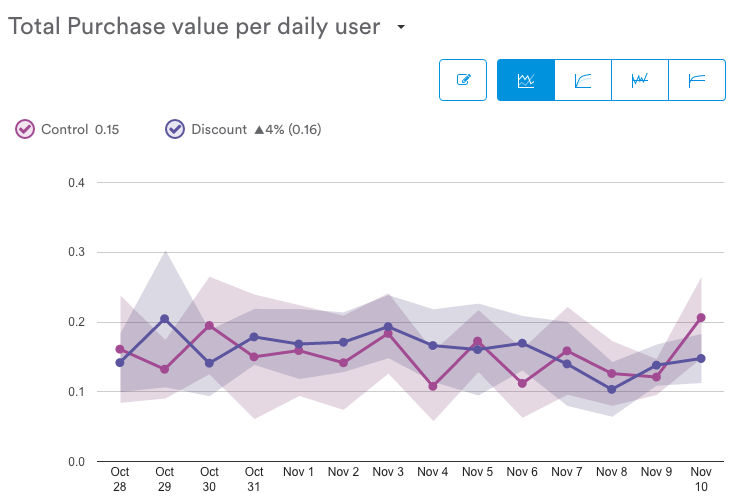

下の図は値引き商品がDAU当たりの総売り上げに与えた影響を比較したA/Bテストの結果です。

ドル表記でユーザー一人当たりの総売上額が左に表記されています。この例では値引き商品が平均売上額0.16ドルで基準値をわずかに上回っています。

一目見ただけでこのテスト結果はあまり役に立たないということがわかると思います。このテスト結果で約4%ほどの上昇を見せていますが、これは上図、線周囲の影で表されている誤差の範囲内です。この影になっている範囲はテストを通じて重なっているので、値引きが本当に4%の上昇の要因なのか判断することはできません。

これは基準値と変数の間に有意性がないことを表しており、このテストが統計的に有効であるこという証明にはなりません。しかし、本当にそうなのでしょうか?結論付ける前に隠れた成功例を見つけるためにデータを掘り返してください。様々なカテゴリごとに結果をフィルターにかけてみましょう。例えば以下のようなカテゴリが使用できます。

もし集計結果でいい結果が得られなくても、特定のユーザーセグメントには効果が見られることがあります。もちろん「効果」はプラスの場合もマイナスの場合もあります。A/Bテストの目的は何かを見つけることなので、変化のなかったものがマイナスの結果になっても心配しないでください。それを次回に生かすためにメモしておきましょう。

何を集計するかは誰にテストにするかと同じくらい大事なことです。一つの指標を最適化すると(特にそれが間違っている場合には)、ユーザーがあなたの施策に対してどのように反応したかが歪んで現れてしまいます。

例えば、中間コンバージョンを増やす目的の小売事業者のアプリで、「カートに追加」のイベントなど、何かを変更するとしましょう。ユーザーがこのイベントを完了することは重要です。(そうでなければ購入を完了することはありません!)しかし、これはショッピングの最重要項目ではありません。本当に重要な最終コンバージョンは購入の完了です。商品をカートに入れたユーザーのうち何人が支払いを完了させて、収益を生み出してくれるかが大事です。

カートへの追加だけを目標にしてアプリのUIを微調整しても、適切ではない指標を最適化してしまう危険があります。小さいボタンがすぐ近くに配置されたUIを導入したら何が起こるでしょう。ユーザーはもしかしたら「レビュー」ボタンと間違えて「カートに追加」ボタンを押してしまうことがあるかもしれません。「カートに追加」のイベントの指標は上昇するかもしれませんが、コンバージョンは変わらないままでしょう。

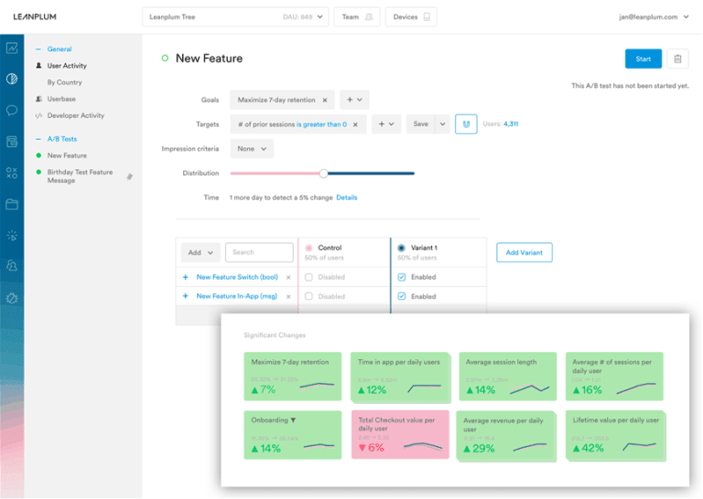

この問題の簡単な解決方法は強引にすべてをテストすることです。これは思うより雑な方法ではありません。Leanplumのような優秀なモバイルマーケティングツールではデフォルトで全ての主要な指標を集計するよう設定しています。さらに統計的に顕著な変化を自動的に浮かび上がらせることで、さらにただの分析の一歩先を行くのです。つまり、すべてを集計するといっても10倍の量のデータをふるいにかけるわけではありません。

アナリティクスのダッシュボードはあなたが注目すべきものをハイライトします。

もし最小限の設定で見たい指標だけ集計したいのなら、すべての重要な最終コンバージョンはA/Bテストに追加する価値があります。それが、最適化によって売り上げを減らさない唯一の方法です。

A/Bテストがいつもうまくいくわけではないという事実を覆い隠す都合の良いものは何もありません。やりたいように試してみてください。データから次の施策を打つヒントになるような知見を得られないかもしれませんが、白紙に戻すことを恥じる必要はありません。A/Bテストを作るとき、仮説を作ることを薦めています。この知識や経験に基づいた正確な推測(質的なものかもしれません)があなたのテストを導く力となるのです。A/Bテストの目的はアプリについての質的な意見を裏付ける量的な証拠を得ることだと言いたくなるかもしれません。

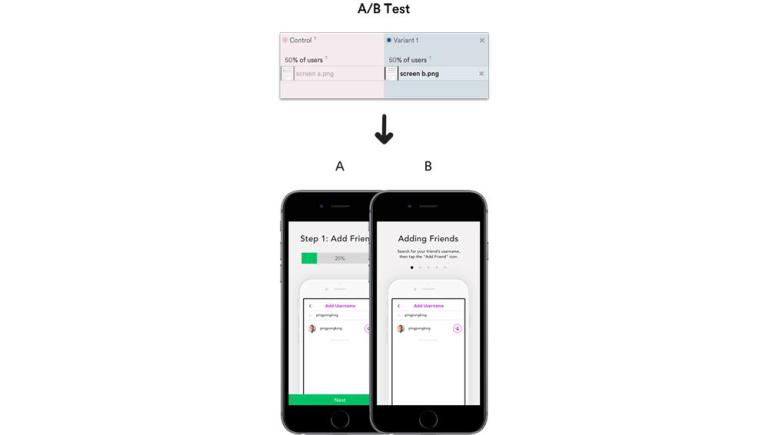

そのため、もしテストが全くうまくいかなかったら仮説を考え直す時です。簡単な例を挙げてみましょう。ユーザーオンボーディングの導線を最適化をしようとしていて、「登録」ボタンの色を何にするか悩んでいるとしましょう。A/Bテストで明るい赤と硬い印象を与える黒を、赤いCTAボタンのほうがより多くの注意を引くという仮説に基づいて比べてみるとします。

しかし、ボタンの色の他に様々な要因がイベントの完了率に関わります。もしかしたら、オンボーディングの導線はすでにうまく機能していて、ユーザーはボタンの色に関わらず「登録」ボタンを押しているのかもしれません。または、黒い背景の上の白い文字は赤い背景の上の白い文字と同じくらい目立つために、ボタンの色の変更によってクリック数は変わらないかもしれません。

もし、両方の選択肢を徹底的にA/Bテストして何も見つけられなかったとしたら、両方のボタンの色が同じくらい効果的だったと推測しても問題ないでしょう。最適な色を見つけるためにさらに微調整する代わりに、仮説を見直し、「登録」を増やす別の方法を見つけたほうが効果的かもしれません。

A/Bテストを行うのは簡単です。しかし、その結果から多くのことを読み取るのは経験を必要とします。実験結果の精査とどの施策がどのように影響を及ぼしたかの特定に励む必要があります。ソフトウェアがその過程を単純にしてくれますが、ユーザーは自分たちが何を求めているのかを明らかにしてく必要があります。

このようなアドバイスがあれば、自信をもって失敗するA/Bテストを打つことができるでしょう。失敗に終わった実験結果を次の実験に生かすことで、モバイルアプリの最適化という長い道のりを進んでいけるでしょう。

この記事は、 LEANPLUM 上の記事 “How to Find Value in a Failed A/B Test “を著者の了解を得て日本語に抄訳し掲載するものです。Repro published the Japanese translation of this original article onLEANPLUM in English under the permission from the author.

Repro株式会社が制作した独自の市場調査資料、ホワイトペーパー、お役立ち資料です。

ほかでは知ることのできない貴重な情報が掲載されているので、ぜひダウンロードしてご覧ください。