2021.02.17

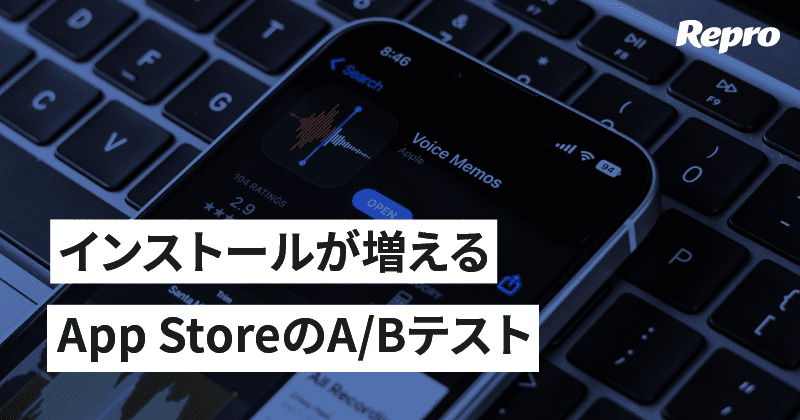

アプリのコンバージョン率を急上昇させるような方法はありませんが、賢くA/Bテストを利用してASOを実施することで大きな成果を得ることができます。

iOSはキーワードの最適化のみではありません。プロダクトページにおけるスクリーンショット、アイコン、プレビュー動画などの要素がコンバージョンに与える影響力は大きく、ユーザーはApp Storeのアプリプロダクトページで最終的に決断します。

ページのさまざまな要素に対してA/Bテストを行うのは、コンバージョン率を最適化するとても効率的な方法です。

しかし適当にテストをしたところで何の結果も得られません。それは、実験が成功か失敗かを判定するために考慮すべき点が非常に多いためです。

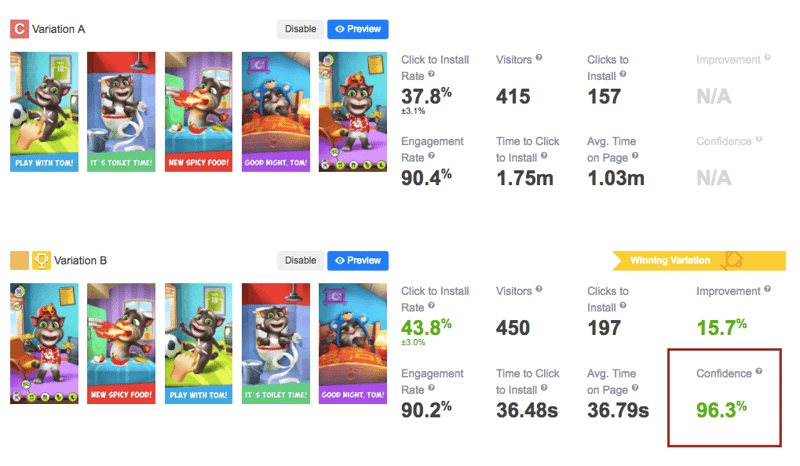

Source: splitmetrics.com

Source: splitmetrics.com

この記事では、コンバージョン率を大きく変える有効なA/Bテストの実施方法を解説します。

準備に時間を費やさずにA/Bテストを成功させることはできません。必ず、次の2点に時間を使いましょう。

事前準備をすればするほどテストは有意義なものになるので、市場や競合アプリ、ターゲットユーザーの調査と分析には十分な時間を使いましょう。

以下のようなステップで調査を始めてください。

競合アプリのアプリプロダクトページを注意深く研究する

アプリのカテゴリーにおけるトレンドとベストプラクティスを決定する

業界のリーダーをより詳しく調べる

アプリプロダクトページの各要素に、ベストプラクティスをどう当てはめられるか検討する

もう一つ考えておかなければならないのは、ターゲットユーザーです。必ず理想的なユーザー像を明確にしておいてください。年齢や性別などの基本情報はもちろん、興味や関心、好みを把握しておきましょう。

こうした情報は、将来App Storeのプロダクトページの制作や広告キャンペーンを行う際に役立ちます。またターゲットユーザーを明確にしたい場合、それぞれのユーザー層でグループを作り、それを比較するA/Bテストを定期的に実施することでターゲットユーザー像をより明確にすることができるのです。

Source: score87.org

Source: score87.org

調査段階にはトラフィックの流入元を特定することも含まれます。どの広告チャネルから熱心なユーザーが入ってきたのか特定することは非常に重要です。この特定にもA/Bテストが活躍します。全く同じターゲットに向けて様々な広告ネットワークでキャンペーンを行い、成果を比較しましょう。

A/Bテストの意義は有効な広告チャネルの特定のみではなく、どんなマーケティングキャンペーンにおいても必要不可欠なのです。

FacebookとGoogle Adwordsが最大のトラフィック源となっている一方、他の広告チャンネルには次のような大きな欠点があると言われています。

* 低クオリティのトラフィックや詐欺などのため、低クオリティなユーザーしか得られない

* クロスプロモーションにおいて、統計的に有意な結果を得られるだけのトラフィックを満たしていない

* スマートバナーを使ったA/Bテストで、非常に長い期間調査を行わなくてはならない(テスト期間の平均は1ー2ヶ月です)

上記のステップ必ず終えた上で仮説の設定に進んでください。A/Bテストではしっかりした仮説設定は欠かせません。

十分に仮説設定をせずに行ったテストはすぐに失敗し、A/Bテストとしての意味を成しません。そのため、証明する価値のあるしっかりとした仮説の設定に時間をかけることは重要なのです。

ところで、良い仮説とはどのようなものなのでしょうか?

優れた仮説は、「はい」か「いいえ」で答えられるような質問です。A/Bテストで何を知るつもりなのか明確にしましょう。A/Bテストにおける仮説には次の要素が必須です。

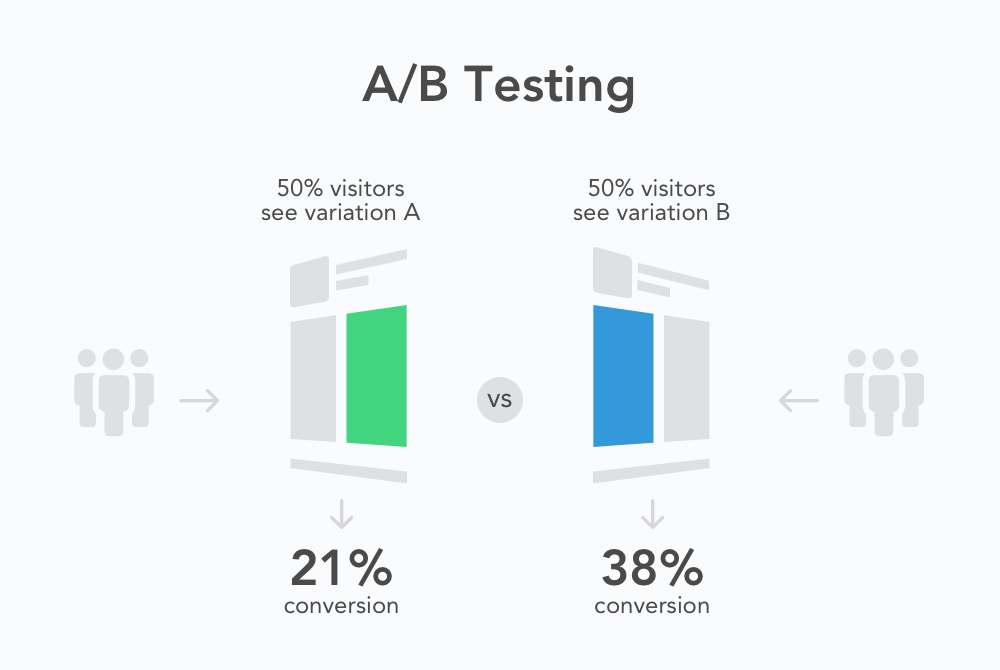

優れた仮説の例を紹介します。

「ターゲットユーザーは熱烈なゲーマーではなく端末を横向きでは使わないため、スクリーンショットを横向きから縦向きに変更した場合、アプリのインストール数が増加するはずである。」

Source: Rovio ‘Angry Birds’ case study

Source: Rovio ‘Angry Birds’ case study

全く同じバリエーションのA/Bテストは無意味です。ゲームアプリのアイコンを同じキャラクターが違うポーズをしているものに変えただけでは大きな成果は期待できません。

それではどんなテストをすればいいのでしょうか?

異なるキャラクターを使う、背景色を変える、キャラクターの表情を変えることなどがあげられます。

調査で発見したベストプラクティスを、テストのインスピレーションとして活用しましょう。

しっかりとした仮説を形成することで、さらなるゴール設定と実験の種類を決定することができます。たとえばスクリーンショットの方向をテストする場合、どんな検証を行うかを決めなくてはなりません。

ここのテストの結果が全体のコンバージョン率を向上させるでしょう。有料のトラフィックから得たユーザーからの結果ならば、非常に重要です。

このタイプの検証では、競合アプリと比較してスクリーンショットがどのような成果をもたらすかを明らかにします。オーガニックのトラフィックで発見してもらいやすくしたいのであれば、必須の検証となるでしょう。

さて、A/Bテストのバリエーションを作成する準備が整いました。

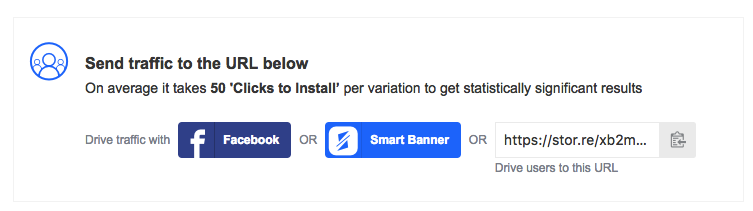

A/Bテストは、よく考慮された適切なトラフィックなしでは成功しません。いくらいい仮説と優れたテストプラットフォームがあっても、トラフィックの品質が低く分量も足りないようでは間違いなく失敗するでしょう。

A/Bテストの実施にあたり、テストを完了する前にトラフィックの割合を高いものにしなければなりません。もしトラフィックの割合が85%であれば、少なくとも1つのバリエーションあたり50インストールを達成し、どのバリエーションがよかったのか確認できます。

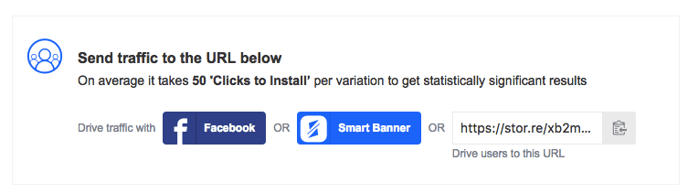

Source:SplitMetrics interface

Source:SplitMetrics interface

テストを意味のあるものにするためにはどれだけのトラフィックが必要なのでしょう?残念ながら、明確な答えはありません。必要なトラフィックの分量は個々のケースよって変わりますが、主に次のような要因に左右されます。

「SplitMetricsの観測によると、統計的に有意な結果を得るには、バリエーションごとに少なくとも50回インストールボタンがクリックされる必要があります。」

平均的に、アプリプロダクトページにはバリエーション1つあたり400〜500人、検索ページやカテゴリーページでテストを行った場合には800〜1000人のユーザーがアクセスしてくれます。この数字が目安となりますが、個々のケースによって大きく変動することは覚えておいてください。

全ての要素は相互に関連しており、十分な注意が必要です。その中でも最も影響が大きい要素のひとつとして、ターゲティングが挙げられます。

上手なターゲティングができれば、トラフィックの割合が少なくても有意な結果を出すことができます。そのため、調査段階で主要なユーザー層を調べておくことは非常に重要です。細かいターゲティングができれば、それだけ結果も優れたものになります。Facebookからのトラフィックが好まれているのは、ターゲティングオプションがとても優れているためです。

こちらもおすすめ:Facebookでモバイルアプリインストール広告でコンバージョン率を高めるための7ステップ

信頼の置ける高品質なテスト結果を保証するため、次の要素を外してフィルタリングすると良いでしょう

ReproでA/Bテストを行えば、内蔵のフィルター機能により無関係のトラフィックを弾くことができます。

Source: SplitMetrics interface.

Source: SplitMetrics interface.

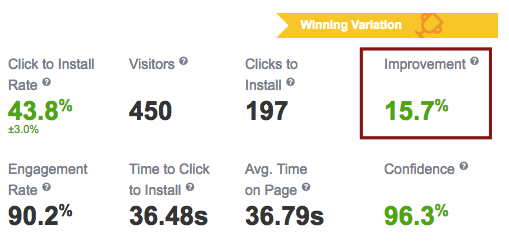

テスト終了の判断を行う上で、信頼性レベルが最も重要であることはすでに述べました。しかし、重要なのは信頼性だけではありません。以下の指標に関しても、同じことが言えます。

「また、少なくともテストを5〜10日間継続することをおすすめします。」

こうすることで、平日を通してユーザーの動向を知ることができ、結果の正確性が高まるのです。

テストが完了したら、仮説が正しいか間違っていたかを検証し、その理由を探しましょう。

ここで何よりも重要になるのが、A/Bテストでは否定的な結果は存在しないということです。たとえ新しいデザインの結果が悪くても、テストを行なったことによって無闇に新しいデザインをアップロードするのを避けられます。つまり、悪い結果をともなうA/Bテストで数千ものインストールを失わずに済むのです。

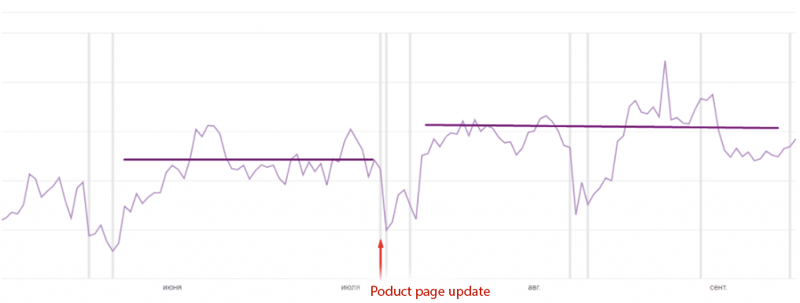

App Storeでは、最も優れていたバリエーションを決定する前にもうひとつ考慮すべき指標があります。それはバリエーションにおけるコンバージョン率が増加したか減少したかです。

Source: iTunes Analytics

Source: iTunes Analytics

どのアプリストアでも環境は変化し続け、周囲にはアプリのパフォーマンスに影響するさまざまな要素があふれています。A/Bテストの有意な結果が欲しいのならば、常に一貫性を保たなくてはなりません。

たとえば、香港のユーザーに対して新しいスクリーンショットをテストしたとしましょう。ここで大きな成果を得たので、ターゲットとしているアメリカのapp storeにアップロードします。しかし、香港でのユーザーから得られたような成果は得られないでしょう。こうした状況では、A/Bテストに価値がないとも言えますが、本当に問題となっているのはターゲティングの不正確さなのです。

同様のことは、Google Playでのテスト結果をApp Storeに適用した場合にも言えるでしょう。AndroidとiOSのユーザーは動向が異なっており、その違いが影響を及ぼします。

つまり、一貫性を保つことが重要なのです。さまざまなコンセプトがあったとしても、テストは一度に1つの要素に対する1つの変更のみにしましょう。そうすることでまぎらわしい結果がなくなり、無駄な労力を減らすことができるようになります。こうしたことに気を付けることでもパフォーマンスの改善が見られるはずです。

正しく時間をかければA/Bテストの実施はASO戦略における安全装置となってくれます。アプリのパフォーマンスをトラフィックに対して向上させるだけでなく、大きなマーケティングにも利用できる指標や分析が得られるのです。

Source: SplitMetrics interface.

Source: SplitMetrics interface.

A/Bテストのトラフィックにおけるサンプルサイズの想定には、専用の計算機を利用した方がいいでしょう。

この記事は、SplitMetrics社のブログ"How to Run Valid A/B Tests on the App Store: Hypothesis, Traffic and Results Interpretation"を著者の了解を得て日本語に抄訳し掲載するものです。Repro published the Japanese translation of this original article on SplitMetrics in English under the permission from the author.

Repro株式会社が制作した独自の市場調査資料、ホワイトペーパー、お役立ち資料です。

ほかでは知ることのできない貴重な情報が掲載されているので、ぜひダウンロードしてご覧ください。